Несмотря на потенциальные риски DDOS атак и других угроз безопасности, многие паблишеры боятся снижения трафика, поэтому не пытаются распознать проблему и закрывают глаза на трафик ботов. Отсутствие эффективного управления ботами может стать риском для всего проекта, может навредить пользовательскому опыту и оттолкнуть рекламодателей от инвентаря сайта.

Боты — приложения, которые автоматически повторяют определенные действия, например индексацию сайта для SEO, сбор контента и получение информации. Боты часто работают через ботнет: соединенные копии программных ботов, запущенные на множестве машин с различными IP адресами. Для владельца сайта боты могут быть полезными, вредными или нерелевантными. Давайте узнаем, что они делают на сайте, и как можно контролировать ситуацию.

Полезные боты. Как их разрешать

Полезные боты созданы для выполнения задач, соответствующих целям паблишера. Один из наиболее распространенных типов — поисковой бот. Он используется поисковыми системами и большинством онлайн-сервисов. Он изучает ваш контент, индексирует страницы и делает ваш сайт доступным при поисковых запросах. Другой пример — сравнительные боты. Они помогают пользователям найти продукты или предложения через сервисы сравнения цен. И, наконец, боты по сбору данных, направленные на сбор контента по определенной теме или предоставлению обновлений о новых постах, прогнозах погоды, курсу валют и т.д.

Вы можете управлять полезными ботами через файл robots.txt, находящийся в домашнем каталоге. Вы можете добавлять интересующих поисковых ботов в белый список или указывать конкретные страницы, которые они должны обработать.

Чтобы избежать необъективной оценки аудитории, вы можете исключить всю активность полезных ботов в Google Analytics. Вы можете задать определенный лист IP адресов, чтобы в аналитических отчетах игнорировать активность поисковых и других полезных ботов от известных источников.

Некоторые полезные боты могут не соответствовать вашим бизнес-целям. Например, боты могут искать на сайте нерелевантный вашему проекту контент. Возможно вам захочется не пускать таких ботов на свои ресурсы. Чтобы сделать это, заблокируйте их IP-адреса или исключите их из списка разрешенных ботов.

Борьба с трафиком вредоносных ботов и атаками на сервер

Цель вредных ботов — различными способами нанести вашему сайту ущерб. Самые опасные из них притворяются настоящими пользователями и обходят систему безопасности сайта, чтобы нарушить его работу. Боты-самозванцы притворяются полезными ботами и вытягивают веб-контент для размещения на других сайтах, сбора данных пользователей и их адресов электронной почты, нарушают правила пользования сайтом и др. Прошлогоднее исследование показало, что больше половины вредных ботов притворяется Google Chrome. Фрод-боты, с другой стороны, действуют скрыто и пытаются украсть информацию, например, личные данные, информацию о банковской карте и т.д., или даже взломать сервера данных.

Распространенный пример вредоносных ботов — DOS и DDOS атаки. DOS атака (Denial of Service, Отказ в обслуживании) проводится с одного устройства, нападающего на уязвимости сайта или посылающего на него большое количество пакетов либо запросов. DDOS атака делает то же самое, но одновременно использует большое количество устройств или сетей ботов. В результате таких атак у сайта-жертвы не хватает ресурсов на обслуживание настоящих пользователей. Очень часто DDOS атаки проводятся, чтобы вынудить владельцев бизнеса заплатить выкуп. Такие боты называются программами-вымогателями.

В некоторых случаях о постоянной активности вредоносных ботов говорит высокий показатель отказов (bounce rate) или чрезвычайно высокое количество просмотров страниц. У настоящих пользователей показатель отказов обычно ниже. Чтобы найти трафик вредоносных ботов, нужно смотреть все сетевые запросы, получаемые сайтом, и анализировать логи для определения подозрительных запросов, нежелательного поведения и аномалий. Например, вы можете заметить резкий скачок трафика из необычного региона, очень короткую пользовательскую сессию.

Естественно, нахождение атаки не предотвращает саму атаку. Как только найдены уязвимости сайта и следы активности вредоносных программ, самое время применять средства и механизмы для их блокировки. В зависимости от логики бизнеса вашего сайта вы можете защитить уязвимые API, добавить капчу в нужных местах, ограничить сетевой трафик по IP или местоположению, установить ограничение на количество запросов от одного пользователя и т.д.

Для больших проектов необходимо внедрять системы управления ботами, позволяющие очень детально сегментировать трафик ботов. Некоторые из популярных решений в этой сфере: Cloudflare, ClickGUARD, Radware и Akamai.

Влияние на рекламу

Боты могут сильно раздувать бюджет на маркетинг и искажать данные кампании. Некоторые облачные сети ботов могут создавать ложные просмотры и клики — кликфрод. Чтобы оправдать доверие участников рекламной экосистемы, паблишеры должны предоставлять точные данные об аудитории и блокировать кликфрод-активность на своих сайтах. Если вы монетизируете сайт через рекламу, и на нем есть кликфрод любого рода или значительно раздутый трафик, большинство рекламных провайдеров будут вынуждены забанить ваш сайт.

MGID гордится тем, что считается платформой, которая в состоянии определить трафик ботов и рекламное мошенничество. В 2020 году MGID получил награду TAG Certified Against Fraud Seal за собственное решение по защите от фрода. Также для гарантии качественного трафика мы используем средство по определению фрода Anura. Помимо этого, у нас есть собственная команда аналитиков, на регулярной основе вручную проверяющая трафик.

Заключение

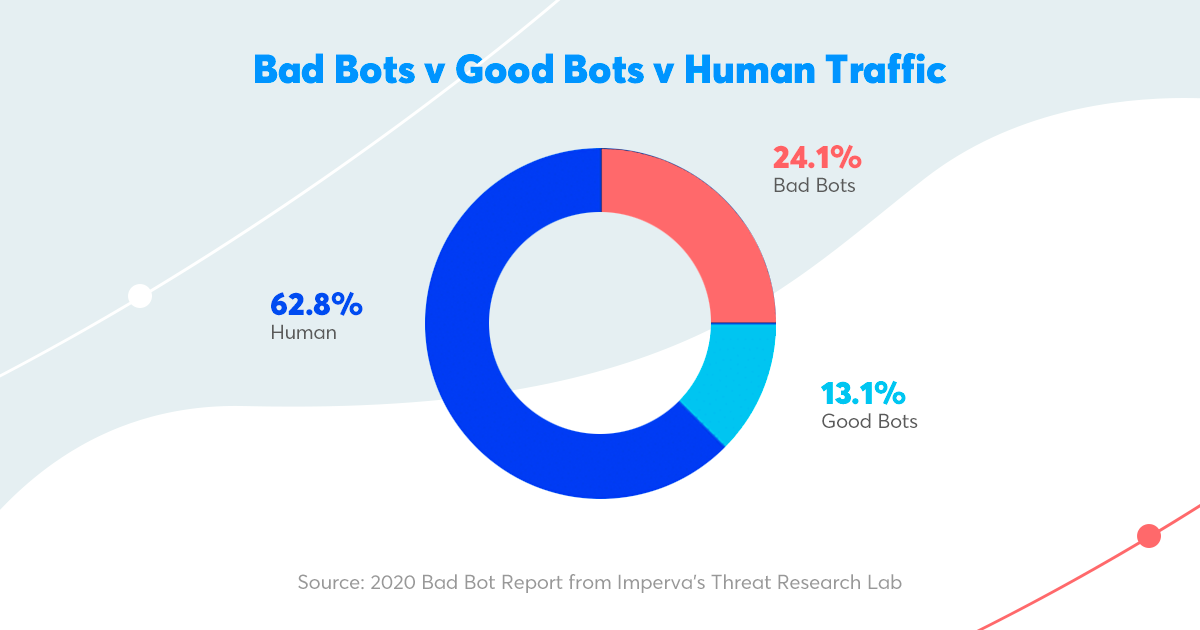

Сегодня 40% всего интернет-трафика является трафиком ботов. Вредоносные боты — это, пожалуй, самая большая головная боль для многих паблишеров. Для защиты сайта от нежелательного трафика ботов мы рекомендуем использовать одно из современных решений по управлению ботами: Cloudflare, ClickGUARD, Radware или Akamai. Наконец, вы можете контролировать полезных ботов, например поисковых, изменяя настройки в файле «robots.txt».